În Sondajul Bitdefender 2025 Privind Securitatea Cibernetică a Consumatorilor, mai mult de o treime din participanți au declarat că sunt îngrijorați de faptul că inteligența artificială ar putea fi folosită ca armă pentru a comite fraude și acte de înșelăciune.

Deși AI promite progrese incredibile, 37% dintre participanți au spus că „utilizarea [AI] în escrocherii sofisticate (ex.: videoclipuri deepfake)” este principala lor preocupare — depășind teama de pierdere a locurilor de muncă și dezinformare.

Așadar, de ce se tem oamenii cu adevărat? În spatele acestei statistici se află o realitate demnă de un serial SF: sisteme AI care pot imita voci sau fabrica fețe și crea iluzii convingătoare — totul pentru a păcăli oameni obișnuiți și a le fura banii.

„Sunt în pericol!”

În Florida, o femeie a pierdut 15.000 de dolari după ce a primit un apel telefonic în care vocea suna exact ca cea a fiicei sale aflată în dificultate. Escrocii i-au clonat vocea folosind tehnologie AI și au construit o poveste credibilă despre o criză care necesita ajutor imediat.

În mod similar, un alt părinte a primit un apel și un mesaj vocal de la cineva care părea a fi fiul lor, susținând că a fost implicat într-un accident de mașină și avea nevoie de 15.000 de dolari pentru cauțiune. Vocea suna suficient de autentic pentru a provoca panică.

Aceste cazuri nu sunt izolate. Poliția Americană avertizează că șantajiștii folosesc tot mai des videoclipuri și înregistrări audio deepfake pentru a pune presiune pe victime înainte ca acestea să reușească să verifice situația.

Fețe sintetice

Escrocheriile bazate pe voce sunt înspăimântătoare — dar impactul AI nu se oprește aici.

În Bengaluru, India, o femeie de 54 de ani a fost înșelată de un videoclip deepfake cu o personalitate publică bine-cunoscută, care promova o platformă de tranzacționare falsă. Ea nu doar că și-a oferit detaliile bancare, dar a și transferat echivalentul a peste ₹33 lakh (~40.000 USD) înainte de a realiza că era vorba despre o fraudă.

La nivel global, conținutul vizual deepfake a fost folosit pentru a imita directori, celebrități și oficiali publici — convingând victimele să investească, să acceseze linkuri periculoase sau să divulge date sensibile.

Într-un incident foarte mediatizat anul trecut, apeluri video generate de AI au fost folosite pentru a imita directorul financiar al unei companii, ceea ce a dus la transferul a peste 25 de milioane de dolari de către un angajat care nu a bănuit nimic.

Amenințarea deepfake la scară largă

Dincolo de fraudele financiare, videoclipurile generate de AI apar în contexte tot mai tulburătoare:

• Deepfake-uri cu medici care promovează medicamente neverificate au circulat pe platforme importante, răspândind dezinformare.

• Videoclipuri deepfake cu figuri ale forțelor de ordine au fost folosite în postări de dezinformare menite să inducă în eroare și să manipuleze încrederea publică.

• Escrocii au folosit videoclipuri false cu personalități politice și lideri pentru a înșela investitori.

Aceste exemple nu sunt ipotetice — sunt cazuri documentate care arată cum AI reduce drastic barierele pentru a crea înșelătorii extrem de realiste, atât în mediul privat, cât și în cel public.

De ce sunt atât de eficiente?

Tehnologiile AI capabile să genereze voci, imagini și videoclipuri sintetice au devenit atât de sofisticate încât chiar și experții au dificultăți în a distinge realul de fals.

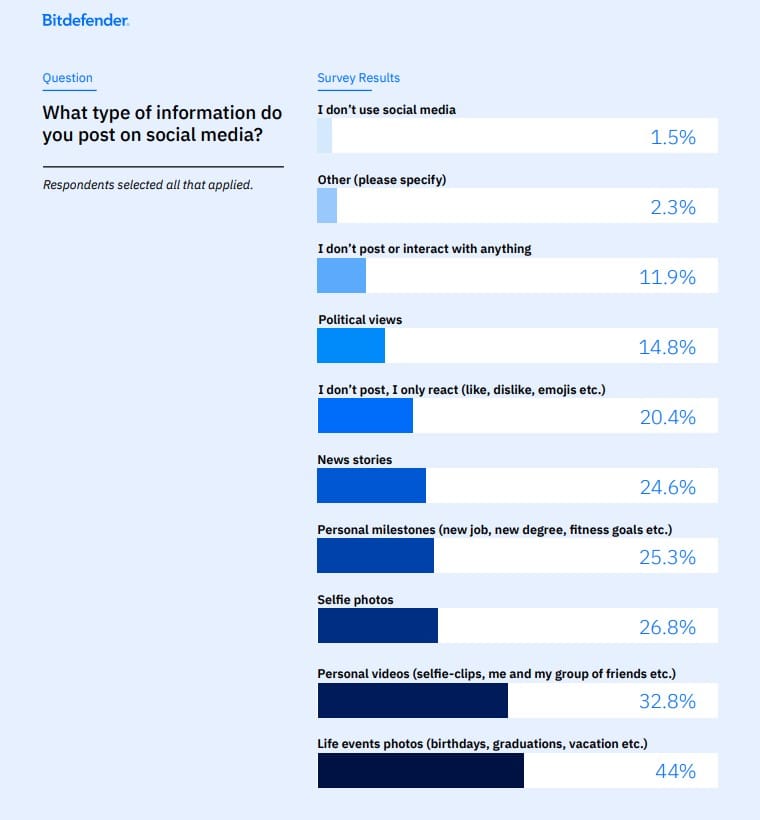

Infractorii pot antrena astfel de sisteme folosind conținut public — postări pe rețele sociale, discursuri, podcasturi — pentru a construi imitații convingătoare cu foarte puține date originale.

În același timp, mulți consumatori facilitează fără să știe aceste amenințări prin divulgarea de detalii personale online sau prin lipsa utilizării unor instrumente de securitate de bază — exact tipurile de comportamente evidențiate în sondajul Bitdefender.

Ce poți face: sfaturi pentru protecția consumatorilor

Iată câteva moduri practice prin care îți poți proteja familia și pe tine însuți în era înșelătoriilor bazate pe AI:

1 Stabiliți un „cuvânt de siguranță” în familie: Dacă cineva sună cerând ajutor, folosește un cuvânt-cod stabilit anterior pentru verificarea instantanee a situației.

2. Verifică solicitările neașteptate: Dacă o persoană dragă cere bani, verifică printr-un alt canal (mesaj, apel video cu camera pornită sau contactând alt membru al familiei). Nu acționa niciodată sub presiune — escrocii se bazează pe frică și urgență pentru a ocoli suspiciunea.

3. Fii sceptic față de conținutul „prea real”: Videoclipurile deepfake și audio-ul generat de AI pot părea extrem de convingătoare. Caută inconsecvențe (pauze ciudate, iluminare nenaturală, nepotrivirea buzelor).

4. Consolidează-ți amprenta digitală: Limitează informațiile pe care le postezi public — cu cât postezi mai puține lucruri despre viața ta, cu atât este mai dificil pentru escroci să îți cloneze vocea sau imaginea.

5. Răspândește vestea: Vorbește cu familia și prietenii — în special cu persoanele în vârstă — despre escrocheriile bazate pe AI. Conștientizarea este una dintre cele mai puternice arme.

6. Raportează conținutul suspect: Dacă dai peste un deepfake sau o tentativă de fraudă, raportează incidentul pe platforma pe care s-a întâmplat și, dacă este necesar, autorităților. Raportarea ta poate salva pe altcineva.

7. Folosește un instrument dedicat detectării escrocheriilor: Scamio, chatbotul nostru gratuit împotriva fraudelor, te poate avertiza despre o potențială amenințare la adresa finanțelor, securității sau confidențialității tale.

de Filip TRUȚĂ, Information Security Analyst at Bitdefender