Nu este o noutate faptul că angajații se bazează acum pe ChatGPT, Copilot, Gemini și alte instrumente de inteligență artificială pentru a lucra mai rapid. Este firesc. Aceste instrumente simplifică scrierea, depanarea, cercetarea și comunicarea zilnică.

Dar o copiere/lipire rapidă într-un prompt de inteligență artificială poate împinge informații sensibile în afara companiei dvs. fără avertisment, iar majoritatea instrumentelor de securitate nu observă niciodată.

Aceasta nu este o greșeală rară. Devine un tipar zilnic.

Inteligența artificială a creat în liniște o nouă cale de expunere a datelor

Instrumentele de inteligență artificială par utile și inofensive. Lipiți un paragraf, un fragment de jurnal sau câteva linii de cod. Încărcați o schiță sau o foaie de calcul. Cereți inteligenței artificiale să le curețe, să le rezume sau să găsească o eroare.

• Se simte privat.

• Se simte în siguranță.

• Se simte ca orice alt instrument.

Dar nu este.

Fiecare lipire, fiecare încărcare și fiecare „ajută-mă să rescriu asta” se întâmplă în afara controlului organizației dvs. Și deoarece instrumentele de inteligență artificială funcționează în ferestrele browserului și în interfețele de chat, acestea ocolesc vechile căi de monitorizare pe care se bazează echipele de securitate.

Observăm acest lucru în toate industriile:

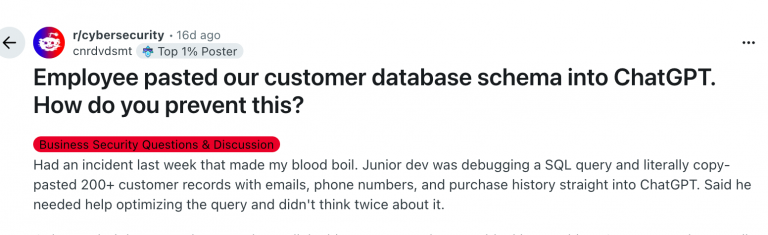

• Dezvoltatorii lipesc cod sensibil pentru depanare

• Analiștii lipesc datele clienților pentru sumarizare

• Resurse umane partajează documente interne pentru rescriere

• Echipele financiare încarcă foi de calcul pentru a curăța formulele

• Echipele de asistență lipesc chat-urile care conțin informații personale.

Nimic din toate acestea nu este rău intenționat.

Sunt oameni care încearcă să-și facă treaba.

Dar instrumentele de inteligență artificială transformă scurtăturile de zi cu zi în riscuri de expunere.

De ce este aceasta o amenințare internă – chiar și atunci când nimeni nu vrea să facă rău

Amenințările interne nu sunt întotdeauna intenționate.

De fapt, cel mai mare risc de astăzi vine de la angajații bine intenționați.

Când cineva copiază informații sensibile într-un instrument de inteligență artificială, se întâmplă imediat câteva lucruri:

• Datele părăsesc mediul dvs.

• Pierdeți vizibilitatea asupra locului în care se duc

• Nu le puteți șterge sau recupera

• Nu puteți urmări cine altcineva le vede

• Nu puteți dovedi ce s-a întâmplat ulterior.

Și din această cauză, expunerea dvs. devine brusc:

• Legală

• De reglementare

• Contractuală

• De reputație.

O singură copiere poate pune o echipă sau întreaga companie într-o poziție dificilă.

• Niciun avertisment.

• Nicio alertă.

• Nicio șansă de a o anula.

De ce DLP-ul tradițional nu detectează nimic din toate acestea

Majoritatea organizațiilor încă se bazează pe instrumentele clasice de prevenire a pierderii de date. Aceste instrumente analizează e-mailurile, transferurile de fișiere, încărcările în cloud, traficul de rețea sau unitățile amovibile.

Iată problema:

Instrumentele de inteligență artificială ocolesc toate acestea.

• Totul se întâmplă într-o casetă de text a browserului sau într-o fereastră de chat.

• Nu există nicio mișcare de fișiere pe care DLP să o examineze.

• Nu există e-mailuri, atașamente, semnături de rețea.

DLP-ul tradițional se așteaptă ca datele să călătorească pe căi previzibile.

Utilizarea IA nu mai urmează aceste căi.

Ceea ce înseamnă:

• Nimic nu este semnalizat

• Nimic nu este blocat

• Nimic nu apare în rapoarte

• Echipele de securitate rămân oarbe.

Acesta este motivul pentru care atât de mulți lideri consideră că IA a apărut mai repede decât s-au putut adapta controalele lor.

Noile controale, organizațiile încep să adopte

Companiile nu interzic instrumentele AI.

Ele ajustează modul în care le utilizează – și adaugă bariere de siguranță simple care reduc riscul fără a încetini oamenii.

Iată ce vedem că fac echipele:

1. Reguli clare de utilizare a AI: reguli scurte și practice despre ce poate și ce nu poate fi partajat cu un asistent AI.

2. Platforme AI aprobate: utilizarea Copilot sau a altor opțiuni de AI ale întreprinderii în cadrul unei entități găzduite guvernate.

3. Reducerea accesului excesiv: limitarea cine poate vedea datele sensibile de la bun început.

4. Ajutarea angajaților să evite greșelile sincere: instruirea oamenilor să recunoască atunci când sunt pe cale să insereze ceva riscant.

5. Adăugarea de protecție la nivelul endpoint-ului: plasarea de bariere de protecție pe dispozitivele utilizatorilor care verifică textul și fișierele înainte ca acestea să ajungă la un instrument de inteligență artificială.

Acestea nu sunt investiții mari. Sunt actualizări simple care elimină decalajul dintre modul în care angajații lucrează astăzi și modul în care companiile trebuie să protejeze datele.

Ce pot face liderii acum

Câțiva pași ajută la reducerea rapidă a expunerii la inteligență artificială:

1. Identificați care echipe utilizează cel mai mult instrumentele de inteligență artificială: majoritatea liderilor subestimează acest lucru. Inteligența artificială este utilizată peste tot – dezvoltare, asistență, resurse umane, finanțe.

2. Cartografiați fluxurile de lucru care implică date sensibile: înțelegeți unde sunt momentele de copiere/lipire cu cel mai mare risc.

3. Decideți ce instrumente de inteligență artificială sunt aprobate: nu toate platformele de inteligență artificială oferă același nivel de control sau confidențialitate.

4. Puneți bariere de protecție pe dispozitive: acest lucru împiedică datele riscante să părăsească endpoint-ul în primul rând.

Nu trebuie să împiedicați angajații să utilizeze inteligența artificială.

Trebuie doar să împiedicați informațiile sensibile să ajungă în locuri unde nu ar trebui.

Concluzie: O acțiune mică poate declanșa un incident major

Copiere/lipire a fost întotdeauna o scurtătură rapidă.

Instrumentele de inteligență artificială au transformat-o în altceva – un nou risc intern, ușor de trecut cu vederea.

Angajații nu încearcă să cauzeze probleme. Încearcă să se miște mai repede.

Cu câteva reguli clare și bariere de protecție moderne, pot face ambele lucruri.

Multe organizații adaugă acum protecție la nivel de endpoint care verifică ce partajează oamenii cu instrumentele de inteligență artificială înainte ca datele să părăsească dispozitivul. Aceasta funcționează atât pentru solicitări simple, cât și pentru încărcări complete de fișiere – în instrumente precum ChatGPT, Microsoft 365 Copilot, Google Gemini, DeepSeek, Grok și Claude sau orice alte instrumente pe care angajații LLM le-ar putea încerca. Aceste bariere de siguranță creează, de asemenea, piste de audit și rapoarte clare, care ajută la revizuirile interne, investigațiile și cerințele de conformitate.

de Zoran Cocoara, Director of Enterprise Sales la CoSoSys